Jakie telewizory są najlepsze do HDR-u?

Choć jest to pytanie na osobny obszerny artykuł, nie ma na nie jednoznacznej odpowiedzi. Telewizory OLED oferują jasność niższą od najlepszych LCD, ale ze względu na możliwość kontroli emisji światła na poziomie subpiksela potrafią dużo lepiej lokalizować efekty HDR. Z kolei zaawansowane telewizory LCD wyposażone w wielostrefowe podświetlenie o dużej mocy mają jasność kilkukrotnie wyższą od OLED-ów (np. 2000 cd/m^2 zamiast 700 cd/m^2 w typowych OLED-ach).

Problem w tym, że nawet posiadając kilkaset stref wygaszania, elcedeki nie są w stanie tak precyzyjnie lokalizować efektów HDR, jak OLED-y 4K mające ponad 33 miliony elementów generujących światło. Jak powiedział mi jeden z czołowych japońskich inżynierów, zapytany o to, który jest lepszy: „OLED? LCD? One są po prostu inne”.

Jaka powinna być jasność telewizora 4K HDR?

Jaką jasność powinien mieć telewizor 4K HDR dla Kowalskiego, który chciałby zobaczyć efekt HDR, ale za niego nie przepłacać?

Większość tzw. „telewizorów 4K HDR”, które dominują na rynku nie przekracza 350-380 cd/m^2. Moim zdaniem, aby nabyć coś wymiernie lepszego od pseudo ha-de-er-owej masówki (choć nadal dalekiego od prawdziwego HDR-u) warto rozejrzeć się za ekranami o jasności co najmniej 500 cd/m^2.

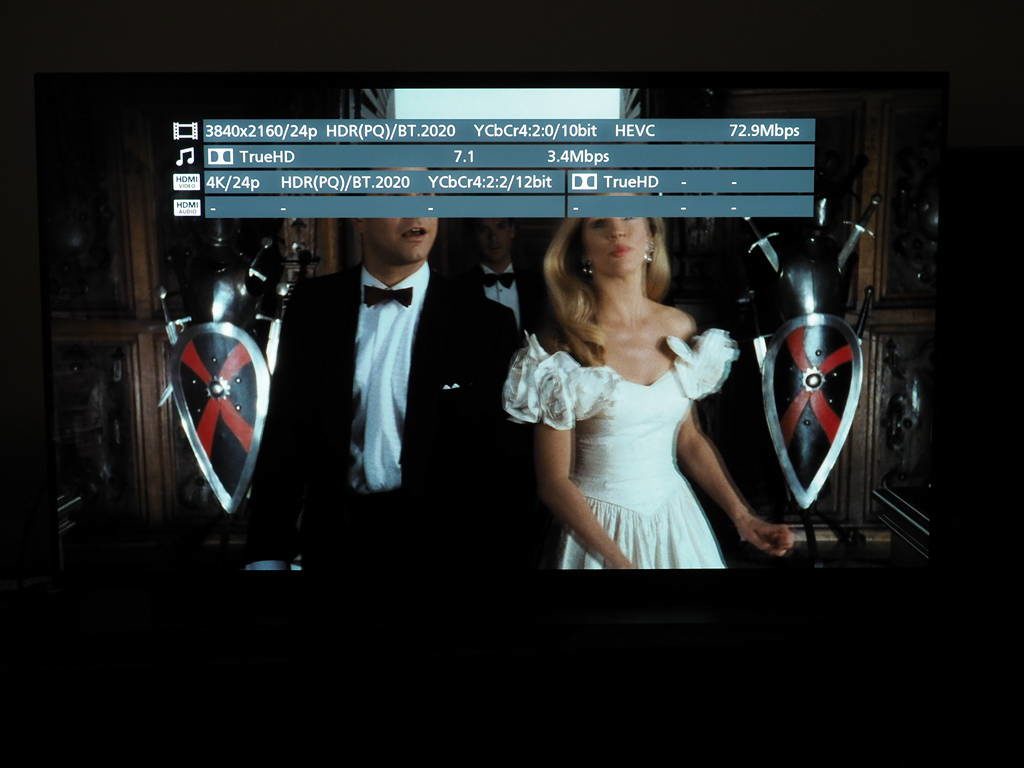

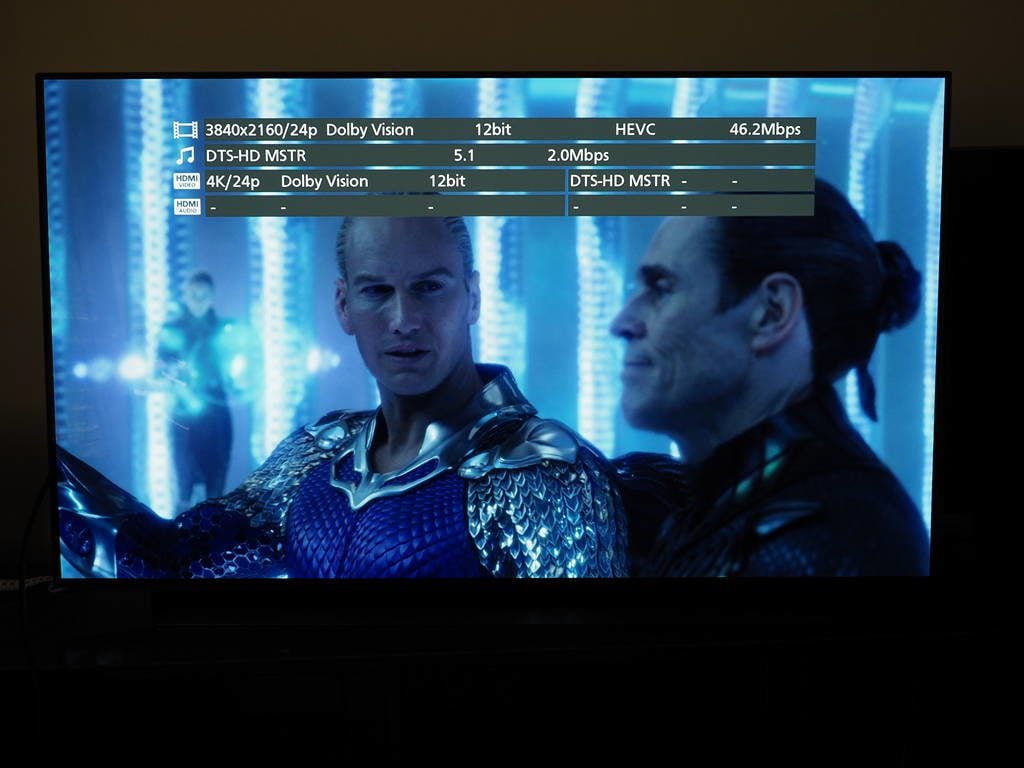

Panie Tomaszu czyli dobrze rozumiem, jeżeli moim odtwarzaczem płyt Blu-ray 4k uhd jest Xbox one X który posiada tylko obsługę hdr10, to jak będę chciał obejrzeć np. nowego Hobbita czy władcę pierścieni odnowionego w 4k w Dolby Vision, to Xbox bez problemu przekaże obraz do tv który ma też obsługę tylko hdr10? Czyli obraz zostanie przerobiony z 12 bitów na 10?

Nie powinno być problemu. Główny strumień danych zapisany na płycie jest w formacie HDR10, natomiast w DV jest strumień dodatkowy, który zawiera informację różnicową (dwóch pełnych strumieni nie dałoby się zmieścić w przypadku filmów o typowej długości). Inaczej mówiąc, HDR10 jest obowiązkowy, a DV nie. Jeżeli TV dogada się poprawnie z konsolą przez EDID to prześle mu ona sygnał tylko i wyłącznie w formacie, który telewizor obsługuje, czyli w HDR10.

Czemu filmiki na YT w HDR wolniej się ładują?

Fajny standard stworzony dla zabicia LCD-kow.

Powyzej 1000nitow na LCD TV to moze TV tzw. semi-outdoor.

Telewizory outdoor powiedzmy 1000-4500nitow maja kontrast zblizony do pierwszych kineskopowych tv z lat 70tych.

LCD powyzej 1000nitow po prostu sie nie sprzedaje ze wzgledu na duza degradacje paneli spowodowana temperatura pochodzaca od zrodel swiatla takze swiatla UV(a moze przede wszystkim).

Oczywiscie mozna jeszcze powrocic do direct LED z lokalnymi wygaszaniem LED-ow ale te wysoko efektywne LEDY (czas propagacji)zanim sie w pelni zaswieca/wygasza to to trwa i trwa. Statyczne obrazy moze ale w filmie robi sie istny cryrk i dyskoteka.

Generalnie jak ktos chce prawdziwe HDR to tutaj tylko QLED albo niestety OLED. Tylko w sumie po co…?

Jak ktos goni krolika aby go gonic to spoko ale w tym przypadku i tak zawsze bedzie cos nie wspolgralo co uniemozliwy „poprawne wyswietlanie”.

Kupujcie w miare mozliwie najlepiej DOPRACOWANE wyswietlacze (nigdy nie pierwszej i drugiej generacji) za mala kase i tyle. Naganiaczom podziekujcie i omijajcie szerokim lukiem.

Albo sie delektuje filmem samym w sobie albo delektuje sie kolorem swieczki na drugim planie w 43minucie 25sekundzie przez 5 klatek. Nie wiem jak wy ale ja mam ciekawsze rzeczy do ogladania.

Jedni ogladaja filmy a inni ogladaja DEMA.

Ale bzdury piszesz. HDR to ogólnie lepsza widoczność szczegółów, w mrocznych, czy bardzo jasnych scenach, a nie tylko, jak to napisałeś, „świeczka na drugim planie”.

A QLED to niby w czym różni się od klasycznego TV LED, jeśli chodzi o podświetlenie?

Jakby każdy tak jak ty delektował się filmem samym w sobie, to do dziś tkwilibyśmy w epoce czarno-białego kina niemego. Na szczęście większość ludzi myśli bardziej sensownie od ciebie.

HDR is stupidity if you have an average budget. No current screen is compatible with HDR 2000, 4000, let alone 10000 cd/m2, or has 100% coverage of the Rec.2020 gamut. The content will either be compressed and dull, or with clipped whites or blacks. On a normal TV, SDR will look good and without frustration or variation in brightness.

Same path as useless Hi-Res audio on 90% of consumer devices displaying the logo.

Licenses are designed to make you buy, but a movie will always sounds better on a stereo Hi-Fi system than on an ATMOS soundbar at same price.