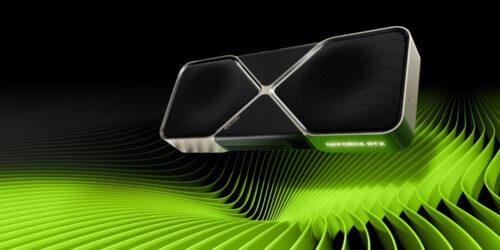

Test GeForce RTX 5080 w grach. Nie o taki skok wydajności nic nie robiliśmy

Na tapet wzięliśmy dwie gry: Cyberpunka 2077 i Indiana Jones i Wielki Krąg, które wyciskają, co można, z ray i path tracingu. Testy przeprowadziliśmy w maksymalnych detalach w trzech rozdzielczościach: 1080p (1920 x 1080 pikseli), 1440p (2560 x 1440 pikseli) i 4K (3840 x 2160 pikseli). Niskie wyniki w Cyberpunku 2077 w natywnej rozdzielczości wynikają z aktywacji bardzo wymagającego path tracingu. Indiana Jones działał bez śledzenia ścieżek.

Różnice między RTX-em 5080 a RTX-em 4080 Super (który jest niemal na równi ze zwykłym RTX-em 4080) są wyjątkowo skromne. Tak skromne, że w najgorszym scenariuszu są one zaledwie kilkuprocentowe (niekiedy wręcz… gorsze), by w najlepszym osiągały 10-15%. Te drugie wartości co prawda trzymają się w granicach oczekiwań, ale iskierka nadziei na to, że NVIDIA Blackwell w tej półce przyniesie większy skok wydajności nie umierała do ostatniej chwili…

Ten wzrost fps wiąże się jednak z podobnym wzrostem poboru mocy (TGP zwiększyło się z 320 W na 360 W), więc trudno tu mówić o jakimkolwiek realnym progresie. To wynika z niemal identycznego procesu technologicznego i zbyt małych zmian w architekturze Blackwell (gdyby NVIDIA chciała, dałoby się tego uniknąć, choć niewątpliwie jeszcze większym kosztem efektywności energetycznej).

To oznacza, że RTX 5080 nie ma w ogóle startu do RTX-a 4090 poza wyjątkowymi grami, które mogą być lepiej zoptymalizowane pod nową architekturę NVIDIA Blackwell i szereg rozwiązań, które ona wprowadza (np. RTX Mega Geometry, które trafi wkrótce do Alana Wake’a 2).

Test RTX 5080 w 1080p

RTX 5080 w Cyberpunku 2077 (natywna rozdzielczość 1080p)

A ja mam gtx1650 gddr6 oc i jestem przeszczęśliwym człowiekiem. W fortnite ustawione max 60 klatek, karta obciążona w 60%, mały pobór prądu. Po co komu 240 klatek? Ludzie nie dajcie sobie wmówić że to jest wam potrzebne!

Niezły trolling, 60 klatek to jak 60hz w monitorze – próbowałeś kiedyś pracować/przeglądać internet na więcej niż 60hz (nie mówię już o graniu)? Przy 120-165hz robi się fajna przepaść ;), powyżej 165 (np. 240) to już faktycznie znikoma różnica…ale nie wmawiaj ludziom, że 60fps jest spoko ;P

Panowie tutaj mówią o dwóch odrębnych aspektach. Ludzkie oko nie widzi powyżej 30 klatek. Więc teoretycznie 60 klatek jest dwa razy więcej niż nasz organizm może zaobserwować. Ale dochodzi tutaj drugi aspekt sprzętowy o którym wspomina Emil. Bo ludzkie dostrzeganie obrazu to jedno a płynność animacji to druga sprawa niezależna od naszego oka. I tutaj Emil ma rację. Jeżeli popatrzymy na klatki/s jako aspekt płynności obrazu jaki się nam pojawia to faktycznie czym więcej klatek na sekundę tym obraz płynniej i szybciej reaguje na każdy ruch w grze. Po co to komu? ano po to że jak się gra to fajnie mieć odczucia takie same jak w realu. Gdy poruszamy głową to wszystko widzimy przed sobą płynne ale w grze jak mamy mało (relatywnie mało) klatek to obraz może skakać przy szybkim obracaniu się graczem. Powoduje to efekt że np jak szybko się obrócimy przy niskim FPS to nagle przed nami może pojawić się przeciwnik który niejako wyskoczy znikąd a tak naprawdę on tam był tylko komputer nie nadążył nam tego pokazać bo miał za mało klatek/s. Więc podsumowując naszemu oku wystarczy nawet 30 klatek na ekranie aby nie widział migotania kolejnych klatek obrazu. Ale żeby gra na ekranie płynnie się poruszała przy bardzo szybkich zwrotach bohatera czy przy szybkiej akcji to wtedy czym więcej klatek tym lepszy efekt płynnego obrazu. Dlatego wysokie FPS nie ma znaczenia dla oka ludzkiego i migotania a jedynie dla technicznego upłynnienia ruchów postaci i obrazu na ekranie 🙂 mam nadzieję że ktoś mnie zrozumiał 🙂 Ale Grzegorz też ma rację po części. Jeżeli gramy w gry solo a nie turnieje gdzie liczą się mili sekundy, to nawet 30 klatek jest wystarczające do grania 🙂 Za dawnych czasów jak mi śmigało 15 klatek to też się cieszyłem że mi się nowa gra w ogóle otworzyła na starej karcie 😀

„Ludzkie oko nie widzi powyżej 30 klatek”. Ludzie…

Ja na 2k nie widzie różnicy między 60fps a 120fps, większość gier robi się na 60fps a wszystko ponadto to to jest upscale i luksus. Pomyśl, jeśli musisz sie klócić o to czy różnica faktycznie jest czy jej nie ma, bo znaczna część populacji jej nie widzi, to naprawde jest coś niepotrzebnego. Możesz sobie mówić hurr durr oni nie mają takiego wyćwiczonego oka jak jaśnie pan ja ale to jest po prostu cope. Prawda jest taka że większość ludzi jest ok z 60fpsami.

Ja myśle że to nastawienie na fps to jest jakaś propaganda wielkich firm które chcą żebyście kupowali ich nowe produkty nawet wtedy jeśli wasze stare karty nadal swietnie sobie radzą na najwyższych detalach graficznych. Bo teraz to już nie chodzi tylko o to, nagle chcemy mieć 75…90….120…200 fps, apetyt rośnie w miare jedzenia. Nagle 1080HD nie wystarczy, chcemy mieć 2k, nie 4k, bo inaczej to co? Wstyd? Ja żaluje momentu przestawienia sie na monitor 2k kiedy 1080 robil robote, i byl na tyle maly że ekran byl zawsze w 100% pola widzenia, bez potrzeby kręcenia glową. Jak ten sie zepsuje, wracam do 1920-1080 and 23.5 albo 27 calach….