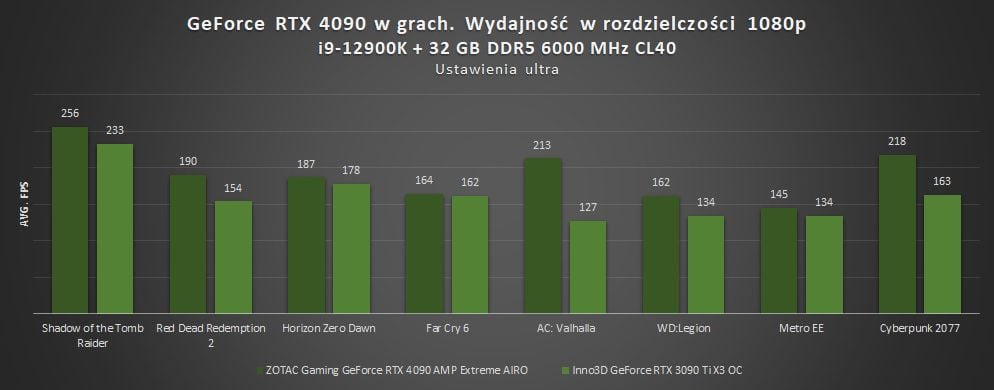

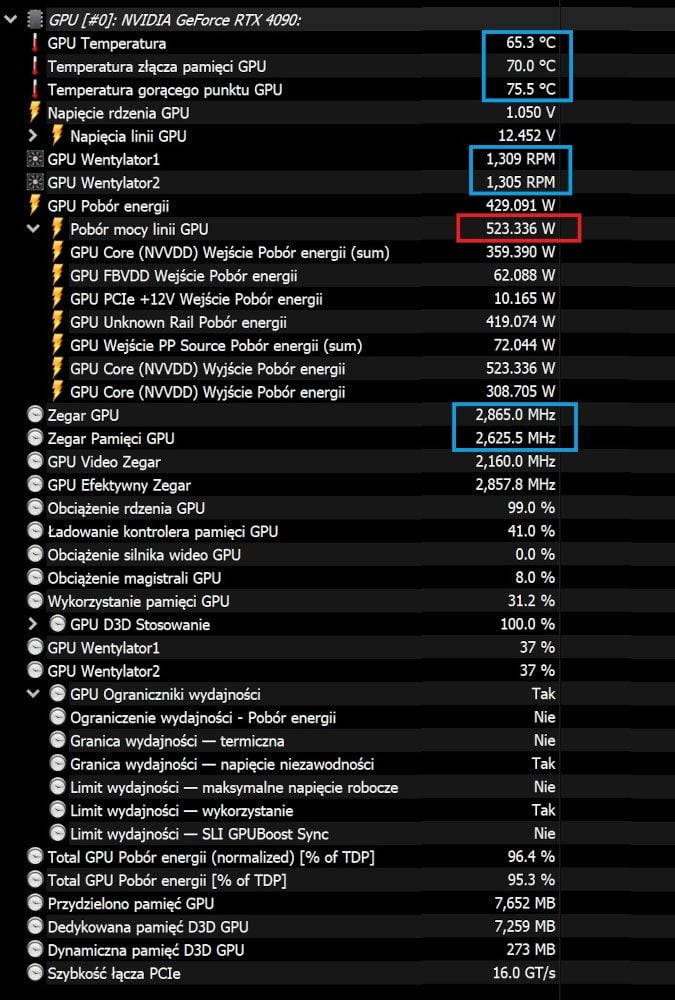

Podczas testów w grze rdzeń graficzny rozpędzał się do ponad 2,8 GHz (rzeczywiste wartości są zawsze wyższe niż podawane przez producentów taktowania w trybie boost). To znacznie przekracza maksymalne wartości, jakie osiągały RTX-y 3000, co też niekorzystnie wpływa na pobór energii. Mimo to RTX 4090 miło zaskakuje, i nie tylko pod tym względem.

Kultura pracy

Karta pobiera dużo energii, a co za tym idzie – wydziela spore dawki ciepła, więc jak poradziło sobie trzywentylatorowe chłodzenie IceStorm 3.0 w modelu ZOTAC Gaming GeForce RTX 4090 AMP Extreme AIRO? Temperatury podczas wymagającego gamingu osiągały 65 stopni Celsjusza (75,5°C Hot Spot), a więc są stosunkowo niskie, jak na takiego potwora.

Przy czym, co ważne, testy odbywały się na komputerze bez obudowy, więc podczas tradycyjnego użytkowania będą one wyższe. O ile? To już zależy od (typu) obudowy, wentylatorów i przewiewności. Karta jest wielka, a chłodzenie masywne, więc skutkuje to dobrymi temperaturami.

A ja to wszystko czytam na i3 7-gen, i „miernym” jak na powyższe standardy radeonie rx570…

Ech, ciekawe po ile nerki chodzą na czarnym rynku…

Wrócimy do recenzji tych diabelsko wydajnych RTX-ów 4000 gdy wejdą niebiańskie RTX-y 5000.

Ciekawe co pan Bartosz Woldański wtedy napisze? A jak oceni RTX-y 6000? Itede, itepe… Za trzy lata ten sprzęt nie będzie znajdywał chętnych, bo będzie zbyt energochłonny względem następnych generacji. Chyba, że przy okazji będzie można tym dogrzewać mieszkanie zimą. Co przy bieżących cenach węgla może jest nawet jakimś pomysłem?

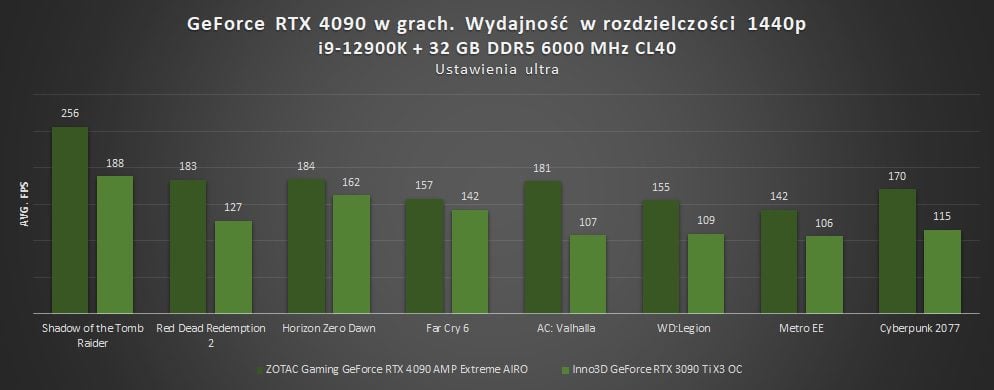

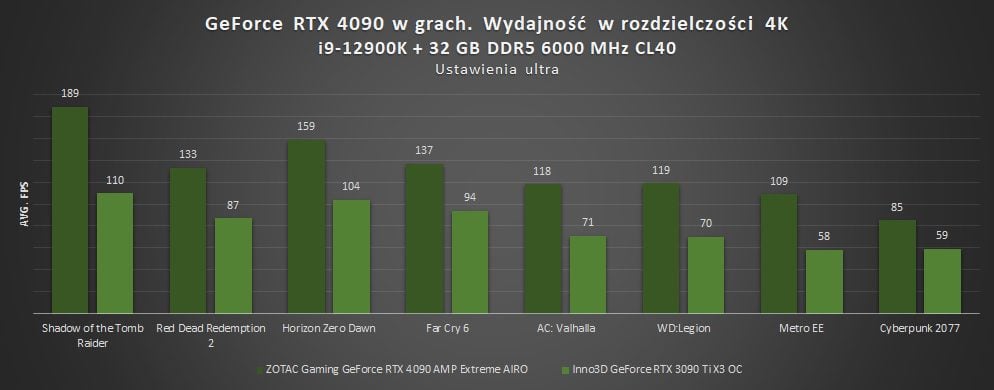

Ocenia się to, co jest teraz. 🙂 GeForce RTX 4090 jest znacznie lepszą kartą niż RTX-y 3090 i 3090 Ti w dniu swoich premier i cechuje się wbrew pozorom naprawdę dobrą efektywnością energetyczną, mimo wysokiego poboru mocy. 🙂 RTX 3090 Ti potrafi mieć wyższy, a wydajnościowo to zupełnie inne poziomy. Tutaj przeskok w procesie technologicznym robi robotę, bo przypomnę, że 8 nm Samsunga to właściwie zoptymalizowane 10 nm. A co będzie w RTX-ach 5000? Pożyjemy, zobaczymy, nie brałbym niczego za pewnik. 🙂

Co będzie jak dojdziemy do 1nm??? Co będzie dalej????????????

Przynajmniej zamiescil jakieś informacje i trochę nad tym siedział a ty tylko narzekasz. Podziel się wiedzą a nie tylko plujesz Jezu.

Prawda jest taka, ze te karty nie sa warte ty pieniedzy, a dlaczego? poniewaz technologia jest zaplanowana na kilka lat do przodu i co roku powstaje nowa lepsza wydajnosciowo i technologicznie karta graficzna tak jest rowniez z kazdym innym podzespolem. To producenci nas oszukuja.

Jakby karty wychodzily raz na 5 lat to ceny po 10tysi bylyby zrozumiale i akceptowalne.