Kiedy premiera NVIDIA H200?

Premiera H200 zaplanowana jest na drugi kwartał 2024 roku. To z pewnością będzie ważny moment dla branży AI i HPC (ang. High Performance Computing). NVIDIA już teraz zapowiada, że H200 będzie kluczowym elementem w nadchodzących superkomputerach, takich jak Jupiter. Ten ma składać się z niemal 24 tysięcy układów NVIDIA Grace GH200 i oferować wydajność na poziomie przeszło 90 eksaflopsów. Jego uruchomienie nastąpi w bliżej niesprecyzowanym okresie 2024 roku.

H200 zmieni zasady gry?

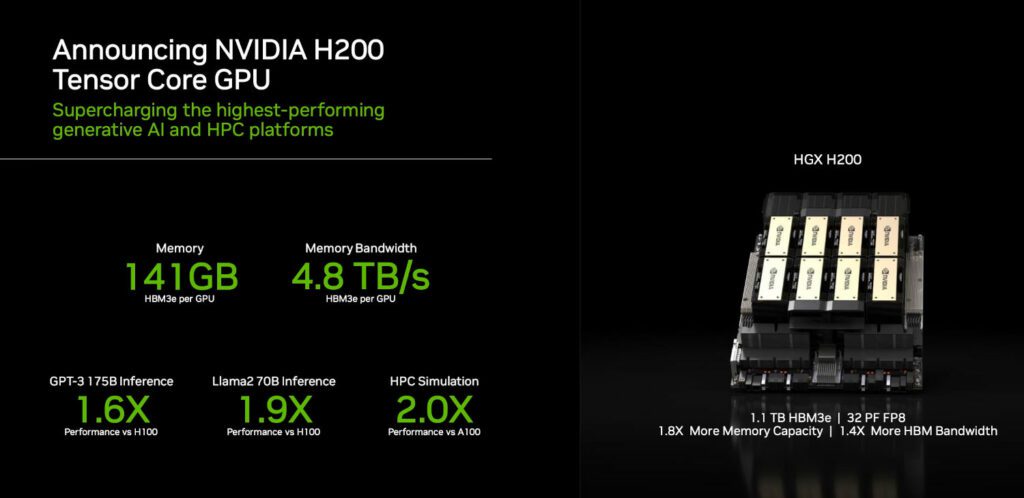

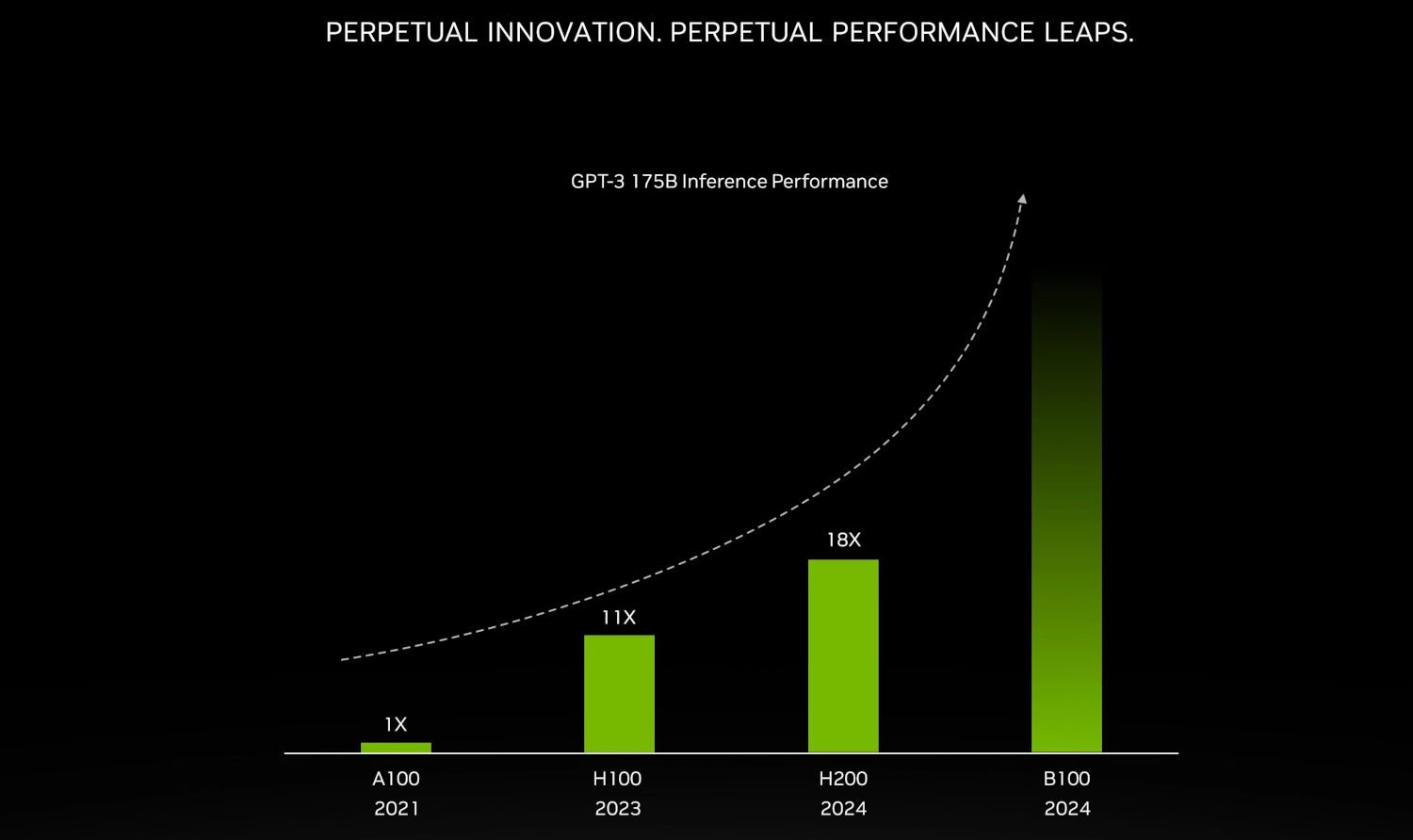

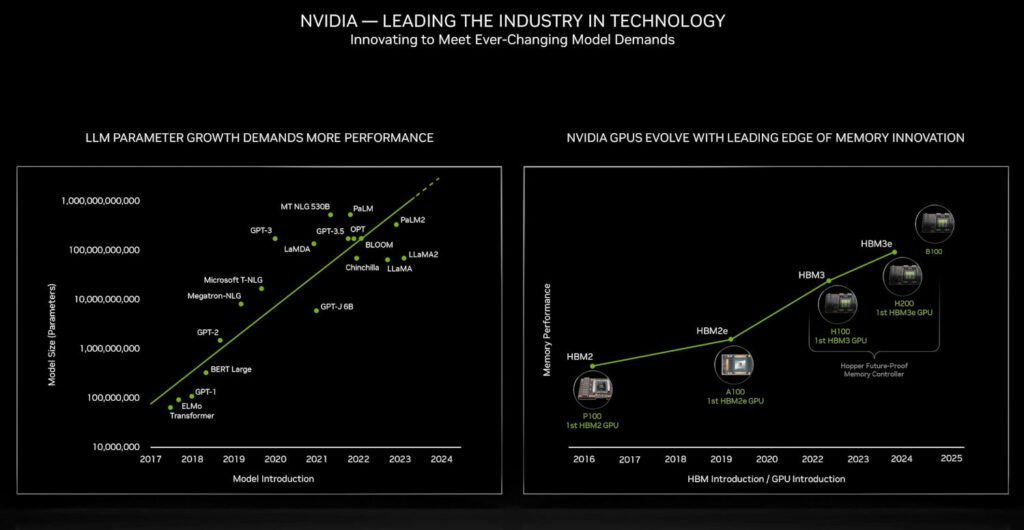

Zapowiada się prawdziwy przełom. Z jego pomocą możliwe będzie przetwarzanie danych na niespotykaną dotąd skalę. To ekscytujące czasy dla wszystkich, którzy interesują się sztuczną inteligencją i modelami językowymi, takimi jak Bing (Microsoft), GPT-3 i GPT-4 (OpenAI), Llama 2 (Meta AI) czy PaLM 2 (Google Bard).