Wszystko szło dobrze, aż przestało

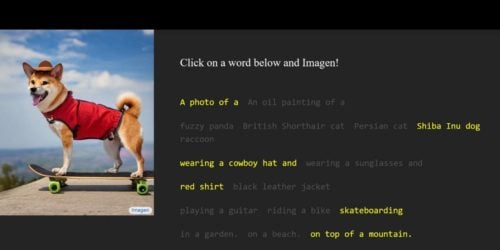

Najgorsze w tym wszystkim jest to, że nie wiemy, dlaczego wszystko działało, aż pewnego dnia system zaczął wypluwać z siebie dziwne słowa, których nie rozumiemy. Słowa to trochę mocno powiedziane. DALLE-E2 prezentuje nam jakieś zbitki literowe, które, najwyraźniej, mają dla niego jakieś określone znaczenie. Niestety nie wiemy, dlaczego w ogóle nam je pokazuje, skoro przecież koza jedząca sałatę, to koza jedząca sałatę, a nie jakiś tam ciąg znaków. 😉

Wydaje się, że zachodzi tutaj klasyczny kazus pod tytułem, „co autor miał na myśli”. Niestety nie możemy programu zapytać, ponieważ to jeszcze nie ten etap. Z drugiej strony, nawet gdyby to był już ten etap, to skąd wiemy, że odpowie prawdę. Człowiek, to czasem mrugnie, spoci się, spojrzy nie tam, gdzie trzeba (no, chyba że KGB go szkoliło) i można wychwycić, że pacjent symuluje. W przypadku sztucznej inteligencji wypluje to to coś na ekran albo wypowie syntezatorem i bądź Pan tu mądry.

Jeden z naukowców przyglądających się sprawie, opublikował na Twitterze ciekawy wątek w tej meterii: